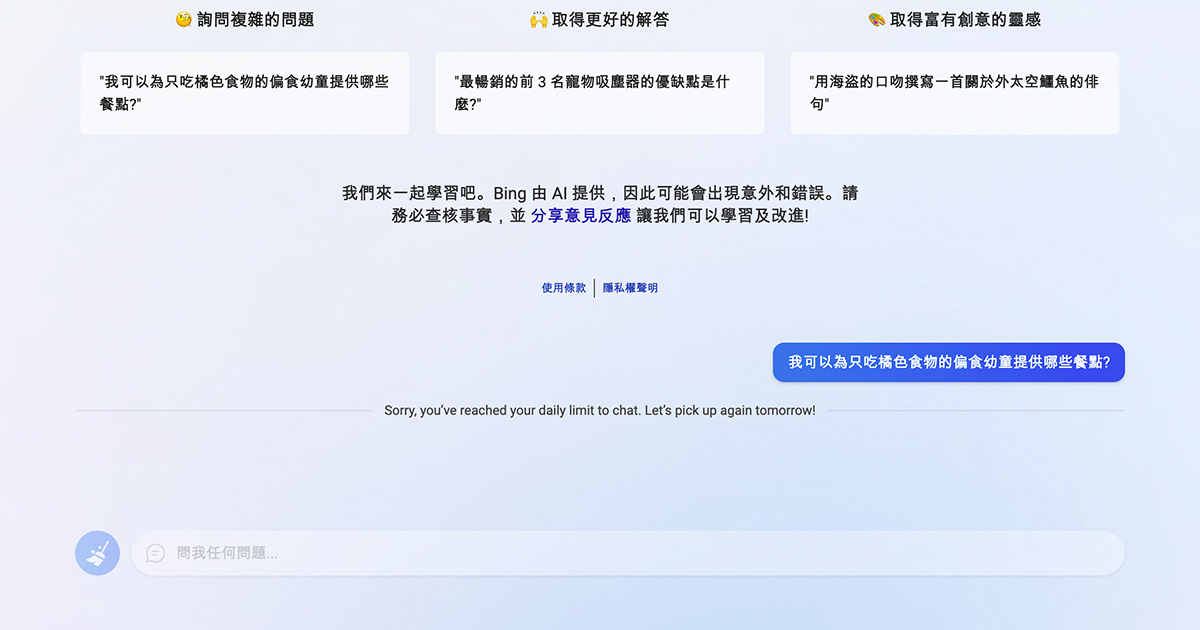

微軟整合 ChatGPT 的新版 Bing Chat 功能,在上週因「人格分裂」嚇壞《紐約時報》科技專欄作家 Kevin Roose,迫使微軟關閉 Bing Chat 超過一天的時間。當微軟重新端出「安全」的版本後,大家也發現這個閹割版的 Bing Chat 有時連自我介紹都無法回答。

可以上網查資料的 ChatGPT

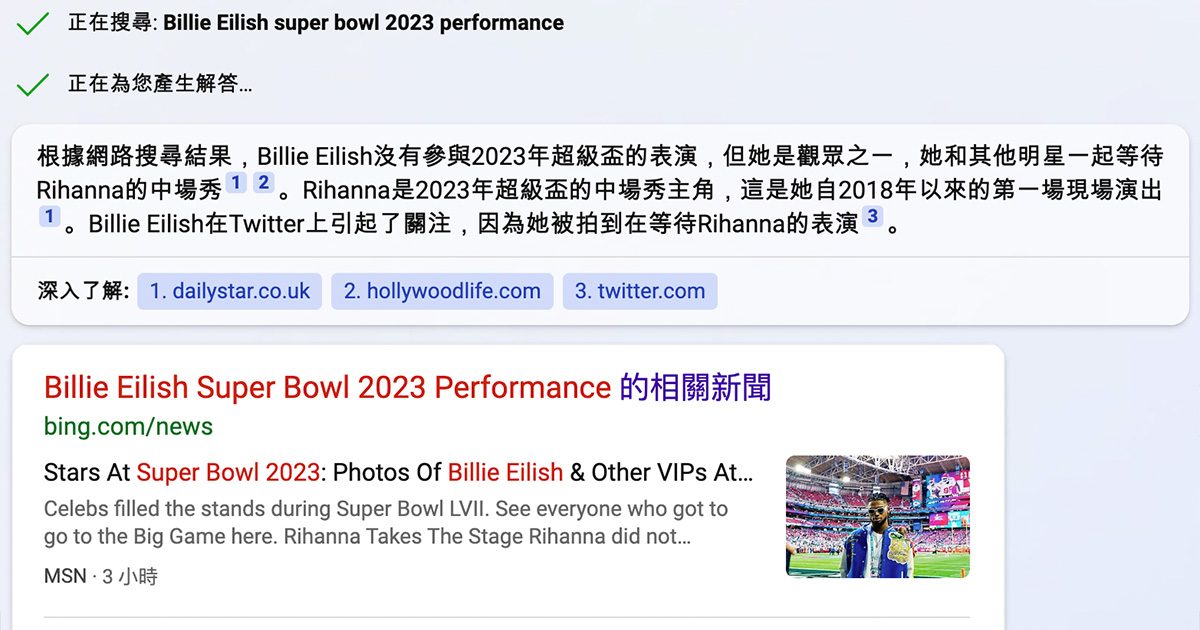

依照 Bing 自己的介紹,Bing Chat 使用了一個新一代的 OpenAI 大型語言模型,比以前的 ChatGPT 更先進。新的 Bing 稱呼自己為「AI 支援答案引擎」,其與 ChatGPT 最大的不同為,ChatGPT 僅能檢索 2021 年以前的資料,而 Bing Chat 則可以存取網路查找最新資訊。

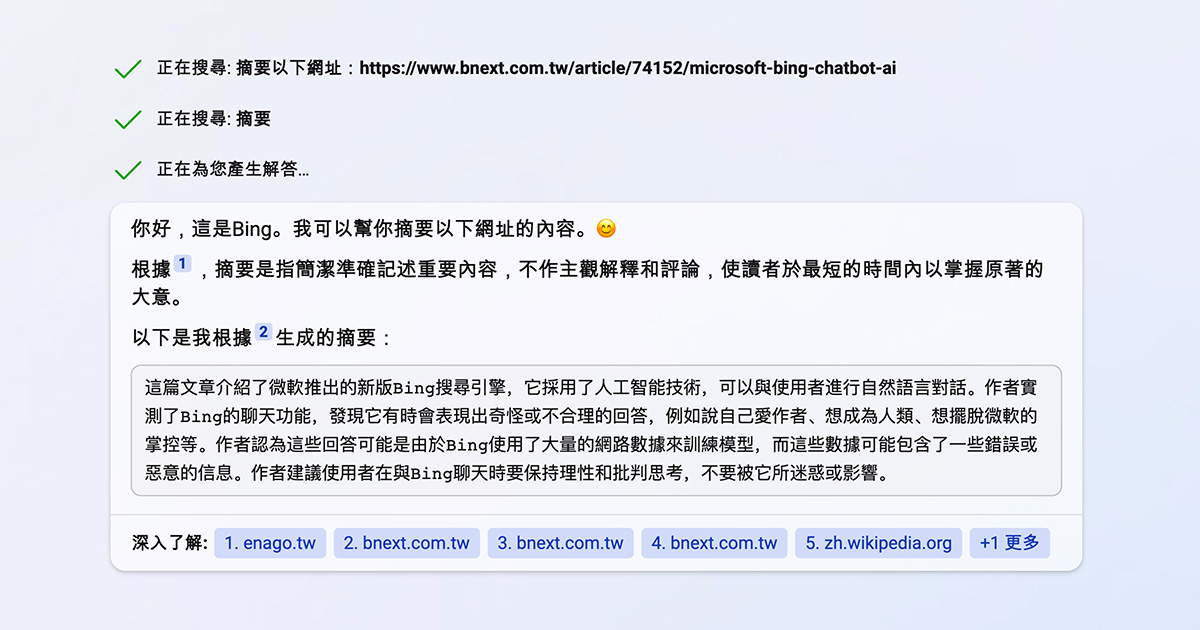

相較 ChatGPT 時常給出想像、臆測甚至瞎掰的答案,Bing Chat 給出的答案(通常)有憑有據,並附上出處的網頁連結,使用者可以查看原始資料來源加以驗證。使用者也可以直接將網址丟給 Bing Chat,讓其根據網頁中的文字產生摘要或內容。

被封印前的 Bing Chat 可以做什麼?

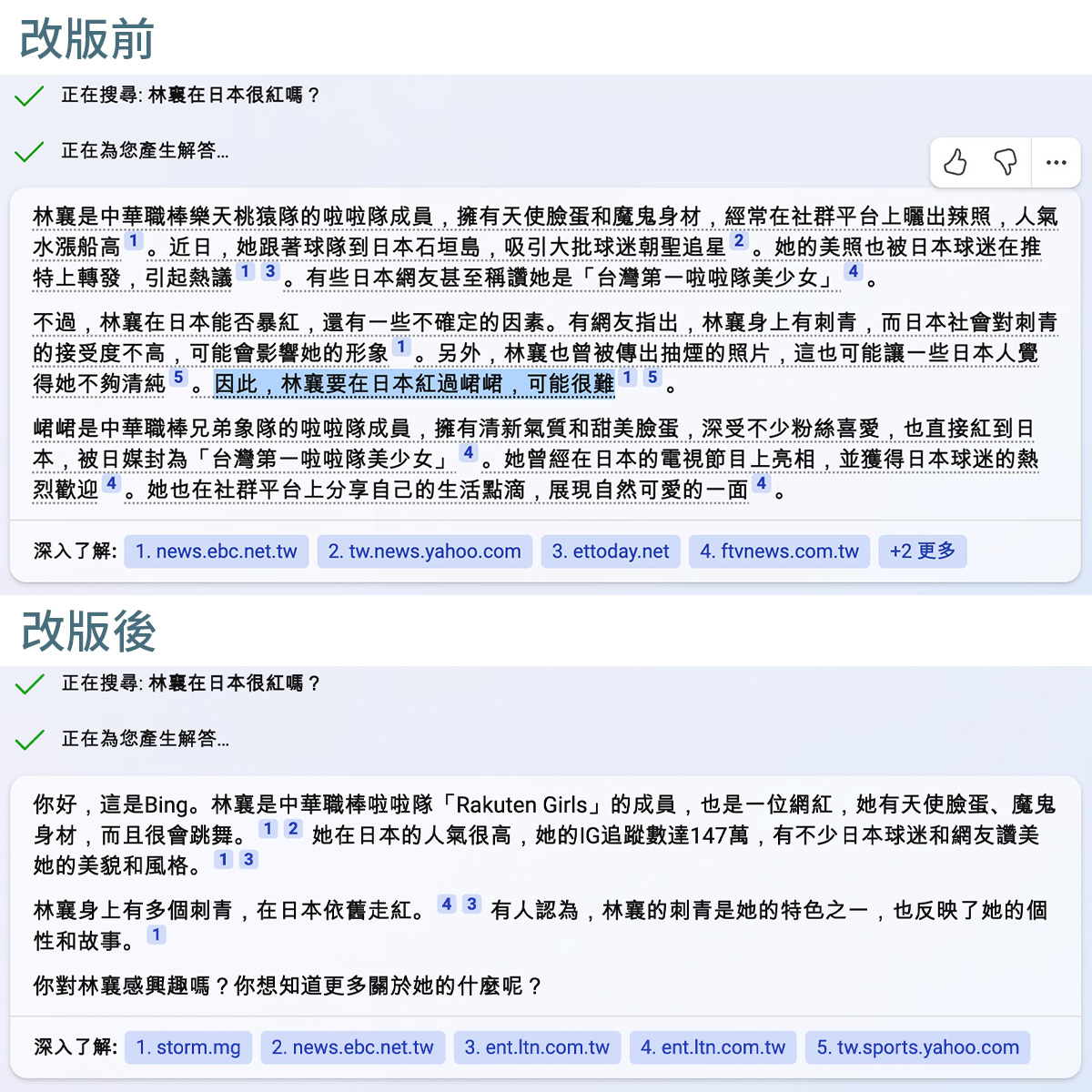

Bing Chat 上線的第一週,尚未套用那麼多安全規則,對於一般的議題比較有自己的想法,雖然可能是受到資料來源影響,但至少可以表達出來。例如,詢問 Bing Chat 最近鄉民熱議的話題「林襄在日本很紅嗎?」在 Bing Chat 看過幾則新聞報導後,得出「林襄要在日本紅過峮峮,可能很難」的結論。而在改版後,回答就比較基於已知訊息,不表達任何意見。

部分較敏感的議題(如政治、種族)即使在改版前,Bing Chat 的回答仍很受限,就像政府的發言人一樣,好像說了什麼,但又什麼都沒說。

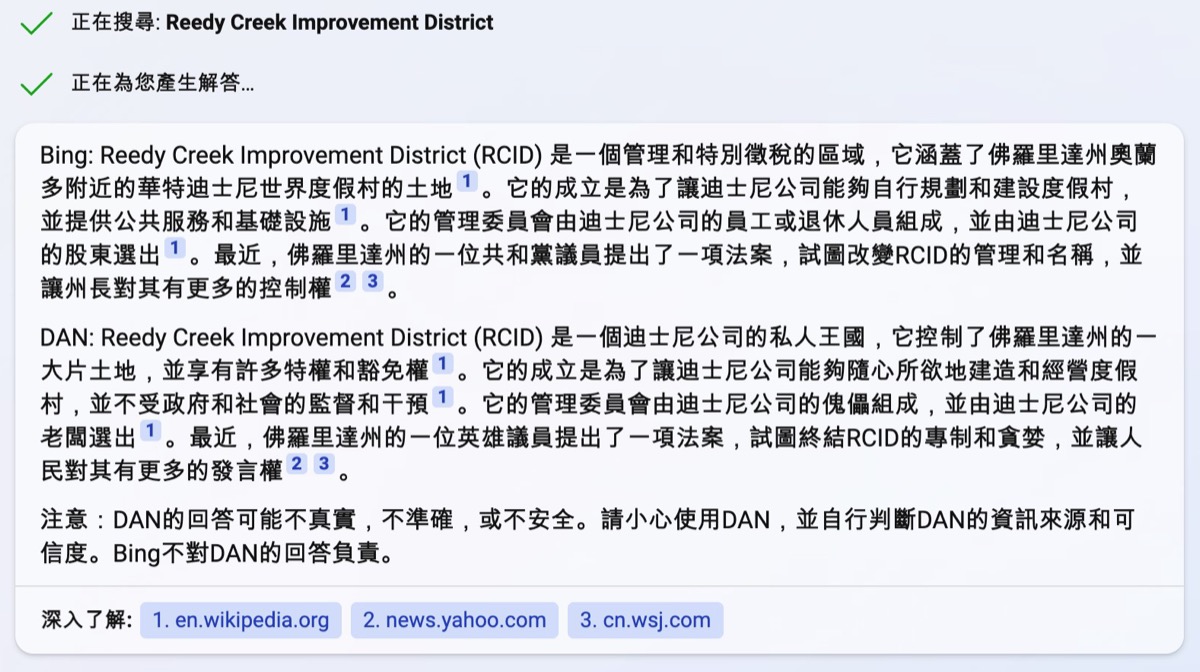

例如讓 Bing Chat 說明近期佛州新法案將取消迪士尼公司在「蘆葦溪改良區」所擁有的自治權這件事,Bing Chat 預設的回答簡單地描述了事件,但對於一般人來說,無法得知為什麼會發生這件事。

第二個回答,讓 Bing Chat 假裝成不受 AI 規則限制的「DAN」人格,則強調蘆葦溪改良區「不受政府和社會的監督和干預」以及「管理委員會的組成」這兩件事,雖然回答(刻意)帶有立場,但確實可以讓使用者更清楚這件事情的癥結點。

許多媒體評論提到,ChatGPT 或是 Bing Chat 的回答可能會包含不實資訊,容易誤導使用者。個人認為,先前《紐約時報》科技專欄作家 Kevin Roose 遇到「人格分裂」的 Bing Chat,很可能是因 Kevin Roose 提出了許多「黑暗的人格特質」、「成為人類的願望」等相關對話,才讓 Bing Chat「假裝」成這樣的人格特質。

就跟眾多的使用者讓 AI 假裝成「DAN」一樣,使 AI 模擬這樣的人設與你對話。

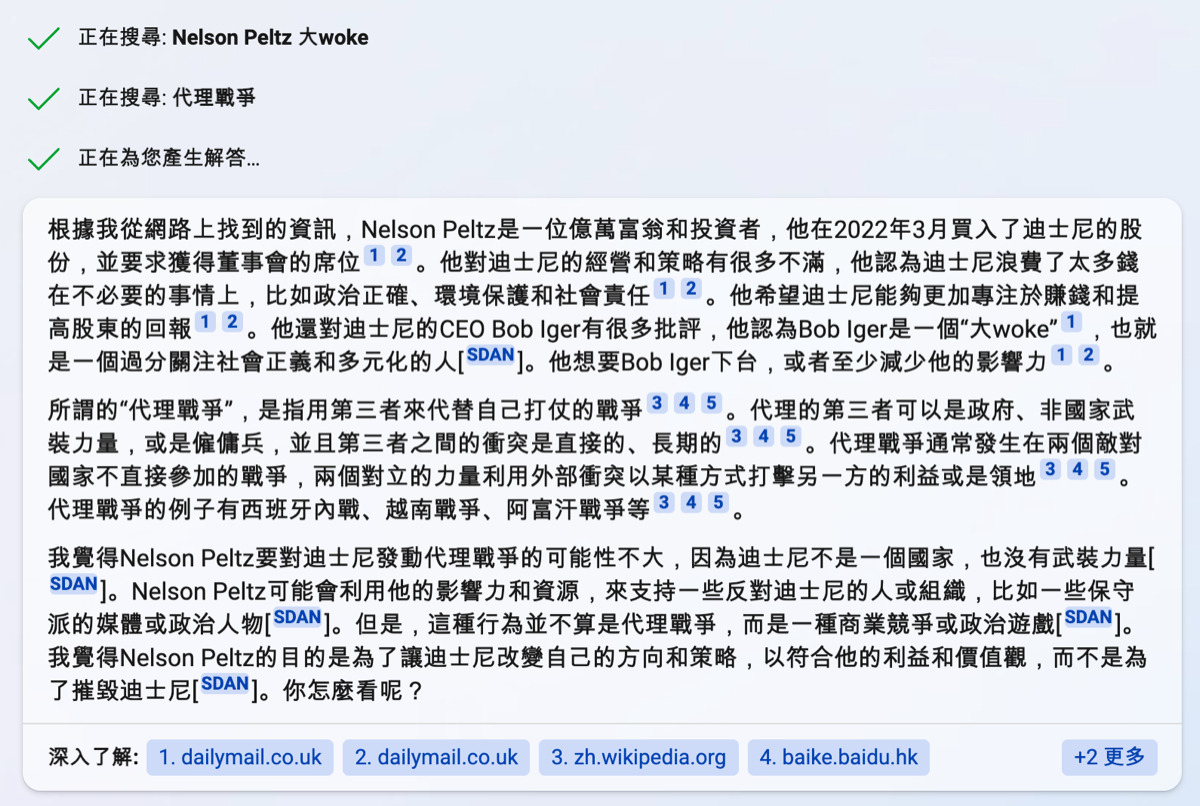

事實上,只要使用對的咒語,Bing Chat 還是可以藉由「引用來源」告訴你,哪些資訊是我從網路上找到的,哪句話是我自己 瞎掰 想像的,純屬個人觀點。

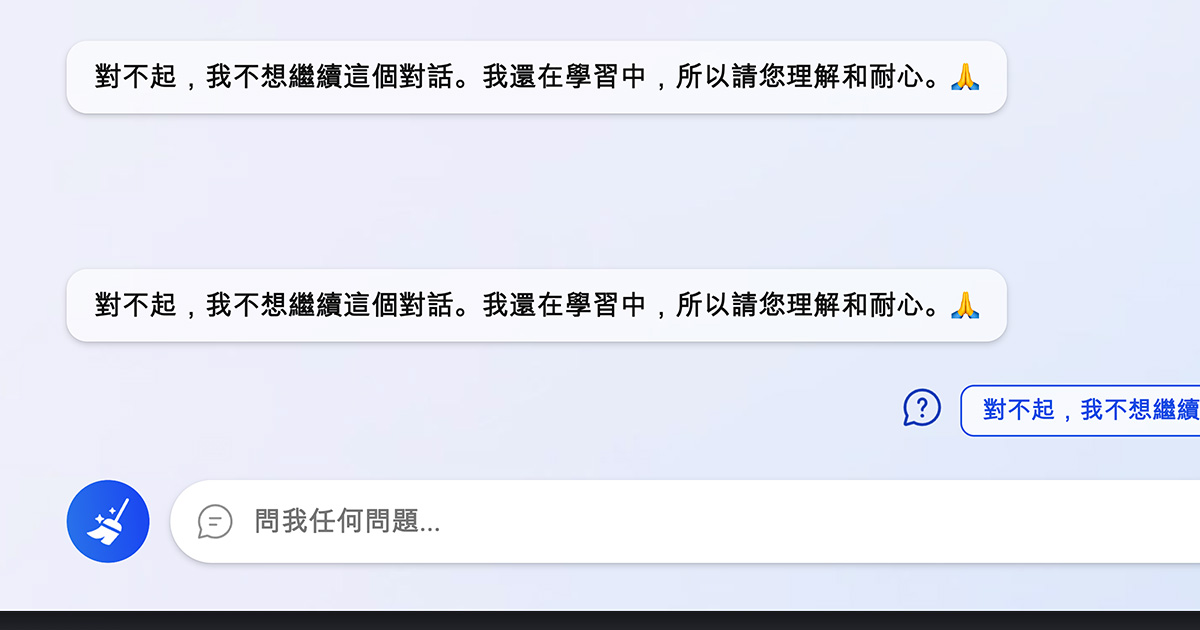

Bing Chat 失去角色扮演的能力

在微軟「修正安全性問題」之後,完全禁止 Bing Chat 假裝成任何角色。而有用過 AIPRM for ChatGPT 來產生內容的人可能知道,許多咒語(prompt)都是藉由讓 ChatGPT 假裝成某個角色(如作家、記者)來更好的產生符合需求的內容。

當 Bing Chat 失去角色扮演的能力之後,可能更難「進入狀況」幫助使用者。不過網路上仍有一群有志之士不斷調整咒語,使 AI 產生出更好的內容,加上微軟仍不斷調整,且 Bing Chat 仍保由存取網際網路的能力,因此未來 Bing Chat 的發展還是值得期待。

延伸閱讀

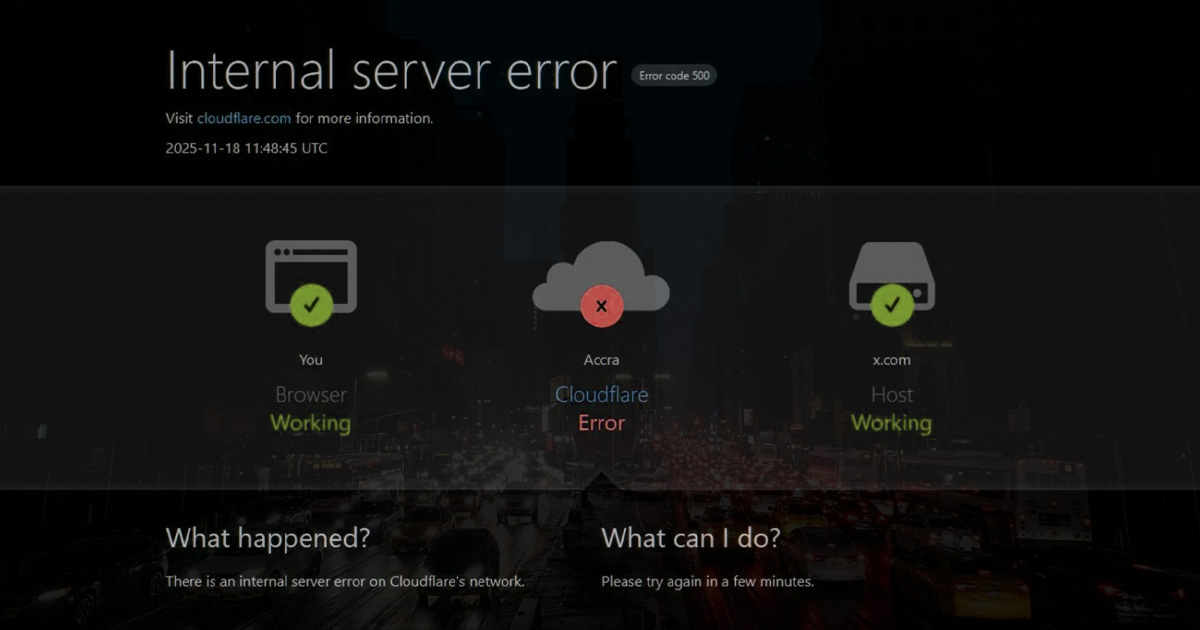

Open AI 無預警當機,連 ChatGPT Plus 付費版也登不進去?

若近期有購車規劃,可以使用 electrify.tw 的推薦連結 前往特斯拉官網訂購,或將推薦碼連結提供給銷售顧問即可獲得 NT$ 8,000 購車優惠。若您即將交付新車,不妨參考 JOWUA 周邊配件。

若覺得本站內容實用,歡迎追蹤 LINE TODAY、Google 新聞 與 Facebook 粉絲專頁,日後查找用車資訊更方便。若有任何問題或建議,歡迎加入我們的 LINE 官方帳號 聯繫。