當 ChatGPT 不再只是網頁上的對話工具,而是能在本機執行指令、管理節點、串接通訊平台時,它的角色就從「聊天介面」轉變為「自動化引擎」。OpenClaw 正是把大型語言模型帶入本機環境的關鍵框架。

本文主要內容

本篇以 macOS Apple Silicon(ARM)為示範環境,實測設備為 MacBook Pro M4 Pro。部署流程採用穩定且容易排錯的順序:先建立標準化系統環境,再安裝執行框架,最後完成 ChatGPT 訂閱驗證與 Codex 模型連線。

目標不是只完成安裝,而是建立一套可長期運作的 AI 代理環境。

先確認你的 Mac 是否為 Apple Silicon(ARM)

如果你的 Mac 是 M1、M2、M3 或 M4 系列晶片,基本上就是 ARM 架構。可以在終端機輸入:

uname -m若顯示 arm64,代表是 Apple Silicon。

這個確認動作看似簡單,但很重要。Homebrew 在 ARM 與 Intel 架構上的安裝路徑不同,後續 Node 與 OpenClaw 也會依照架構選擇對應版本。從正確的系統架構開始,可以避免後續相容性問題。

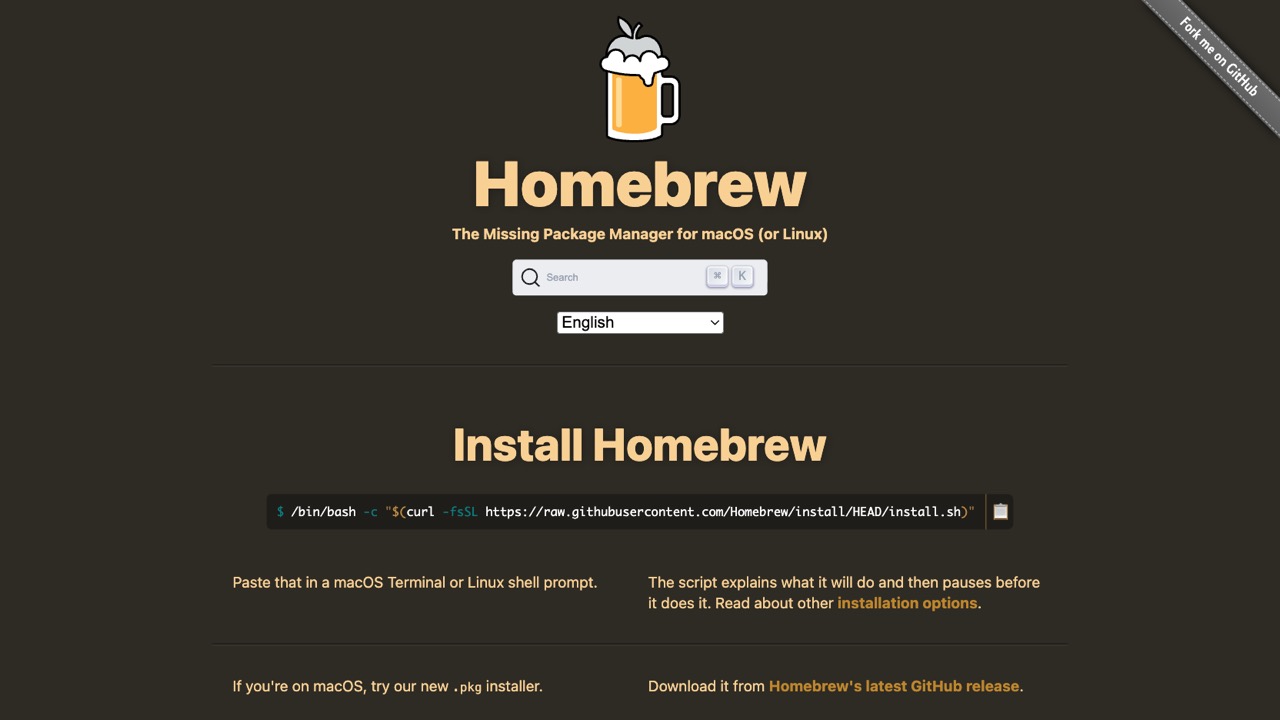

第一步:安裝 Homebrew

如果尚未安裝 Homebrew,可使用官方指令:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"完成後載入環境變數:

echo 'eval "$(/opt/homebrew/bin/brew shellenv)"' >> ~/.zprofile

eval "$(/opt/homebrew/bin/brew shellenv)"為什麼從 Homebrew 開始?

Homebrew 是 macOS 上最成熟的套件管理工具。透過它安裝 Node.js,可以確保版本一致、依賴完整,也能避免常見的權限與 PATH 錯誤。

對於後續部署來說,Homebrew 是整個系統的基礎層。基礎層穩定,後續的代理與模型才會穩定。

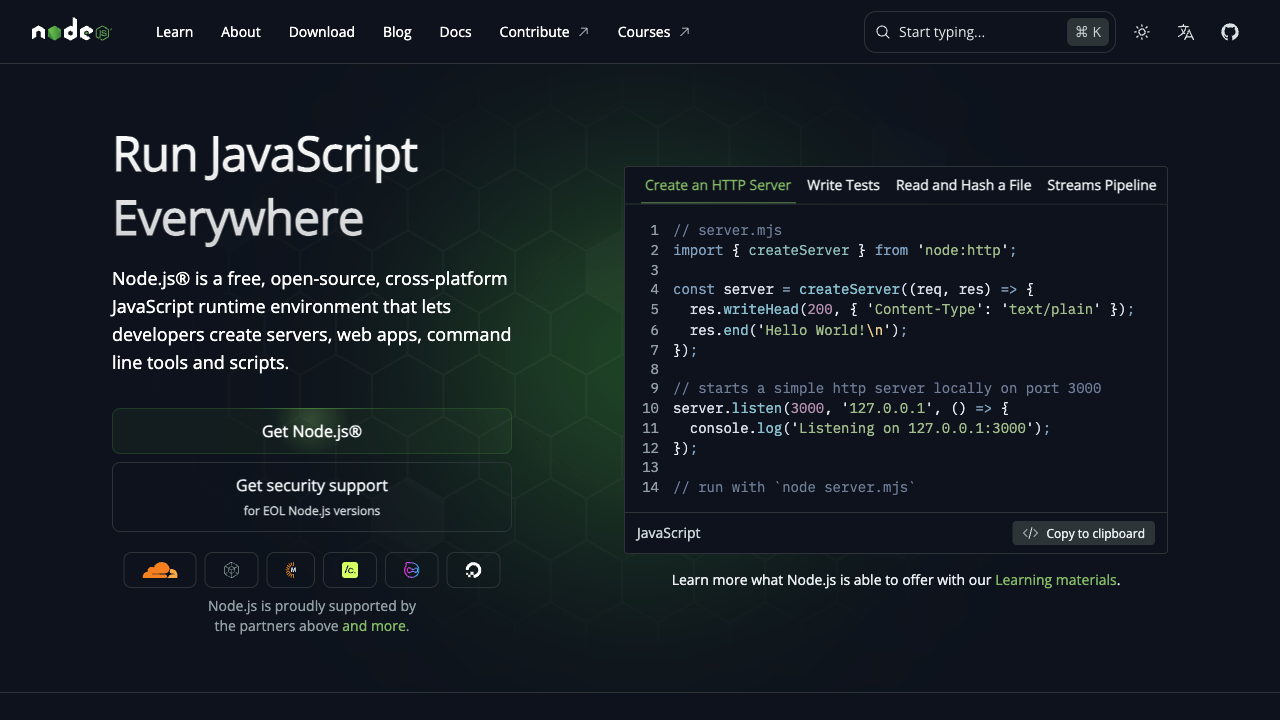

第二步:安裝 Node.js

OpenClaw 是基於 Node.js 執行,因此必須先建立 Node 環境。建議版本為 22 以上。

直接透過 Homebrew 安裝:

brew install node為什麼 Node 版本重要?

新版 OpenClaw 依賴較新的 Node API 與模組管理機制。如果版本過舊,可能會出現模組錯誤或服務啟動失敗的情況。

這一步的意義不只是「裝好 Node」,而是確保整個執行框架符合現行標準。

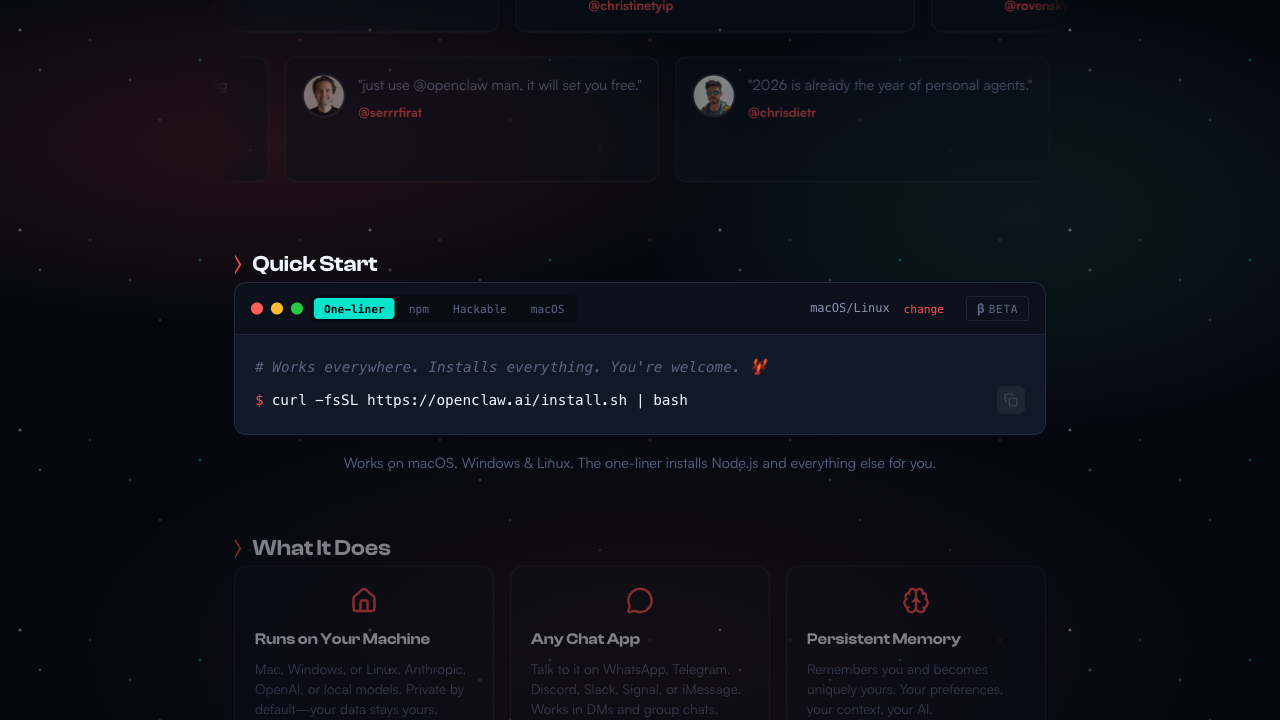

第三步:安裝 OpenClaw(CLI 版本)

有了 Node 環境後,就可以安裝 OpenClaw。

建議使用官方 CLI 安裝方式:

curl -fsSL https://openclaw.ai/install.sh | bash或使用 npm:

npm install -g openclaw@latest

為什麼建議使用 CLI,而不是 brew GUI 版本?

CLI 版本是 OpenClaw 的核心實作層,結構單純、行為清晰,也最容易排錯。部分透過 brew 安裝的 GUI 或封裝版本,可能會與背景服務重複啟動,導致:

- Gateway 重複執行

- 使用不同設定檔路徑

- Port 被佔用

從架構角度來看,CLI 是核心層,GUI 只是操作層。先掌握核心層,系統穩定性會更高。

即使使用 CLI 安裝,最終仍然可以透過瀏覽器開啟 Web Chat 介面進行對話與管理,因此不會失去圖形化操作的便利性。

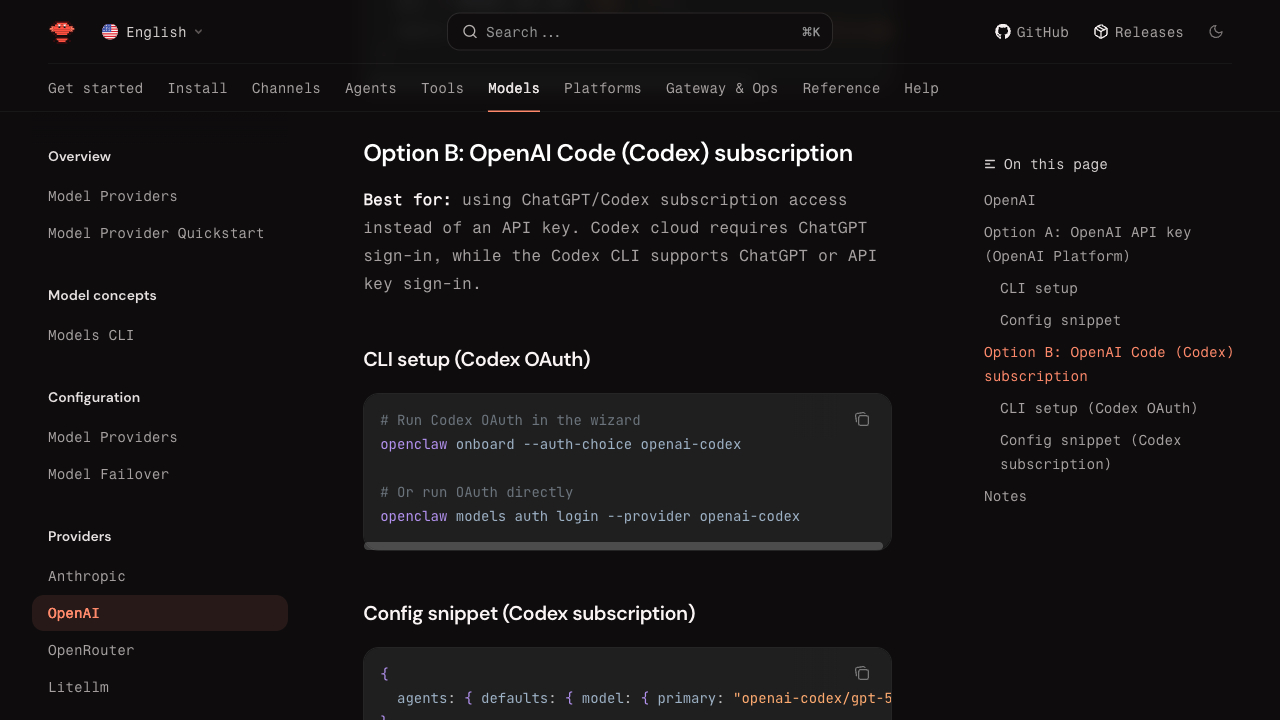

第四步:連接 ChatGPT 訂閱並使用 Codex 模型

安裝完成後,OpenClaw 需要連接到你的 ChatGPT 訂閱,才能真正驅動模型。

建議透過 auth 驗證方式登入,而不是手動貼上 API Key。透過 auth,可以直接使用你目前登入 ChatGPT 帳戶的訂閱權限與可用模型。

執行:

openclaw onboard --install-daemon在互動式流程中選擇:

- AI 提供者(例如 OpenAI)

- 使用 auth 登入驗證

- 選擇可用的 Codex 模型,例如

openai-codex/gpt-5.3-codex

關於訂閱與使用成本

ChatGPT Plus 訂閱每月 20 美元。透過 auth 連接後,OpenClaw 就能直接使用該訂閱下可用的模型權限,包括 Codex 類型模型。

對於一般開發、指令生成與自動化操作而言,Plus 訂閱提供的資源通常足以應付日常使用,不需要額外管理 API 計費或自行控制 token 使用量。對個人開發者或進階使用者來說,這是一個結構簡單且成本可預期的方案。

為什麼選擇 Codex 模型?

Codex 模型在程式碼理解與 CLI 操作方面具備更好的穩定性與精準度。當 OpenClaw 作為本機代理使用時,這類模型特別適合處理:

- 指令生成

- 自動化腳本

- 節點管理

- 技術流程操作

完成這一步後,OpenClaw 就能正式以你的 ChatGPT 訂閱作為後端模型來源。

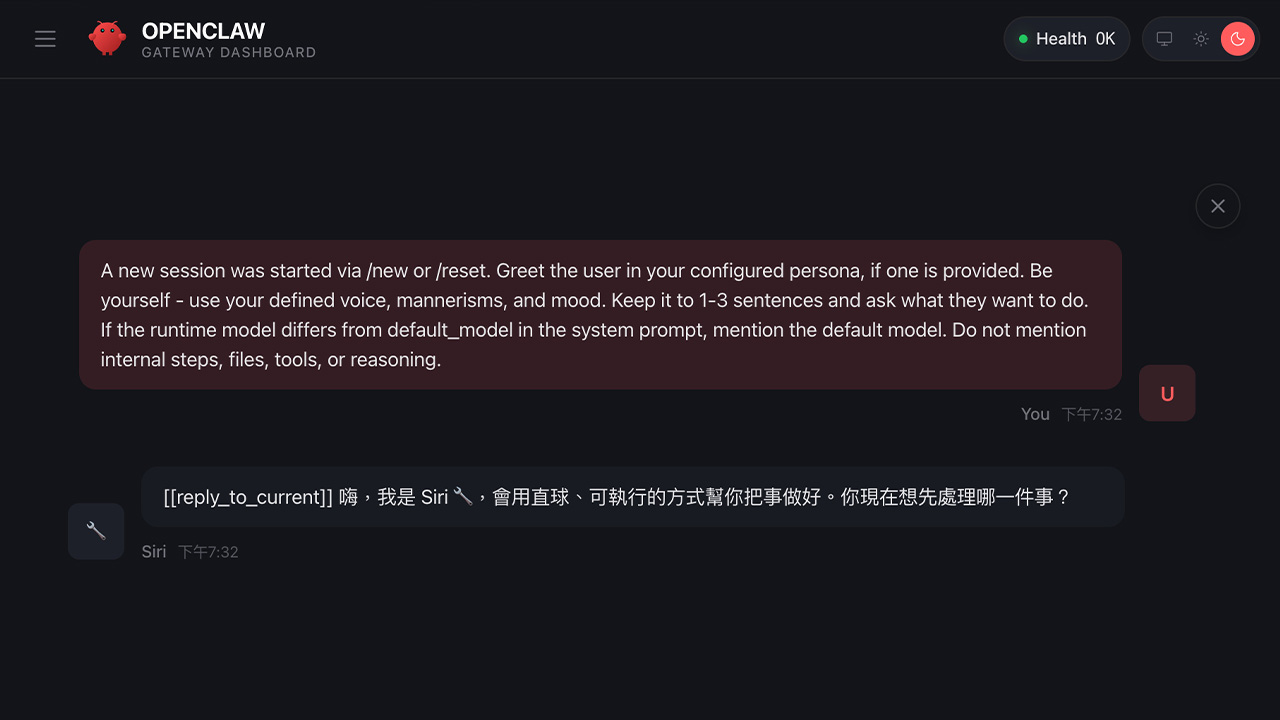

第五步:啟動 Gateway 並開啟 Web Chat

Gateway 是 OpenClaw 的核心服務,負責接收指令、轉發給模型並管理代理狀態。

啟動服務:

openclaw gateway start然後在瀏覽器開啟:

http://127.0.0.1:18789/只要 Web Chat 能正常回應,代表整個代理系統已成功運作。

從這一刻開始,OpenClaw 不只是安裝完成,而是進入可實際使用的狀態。

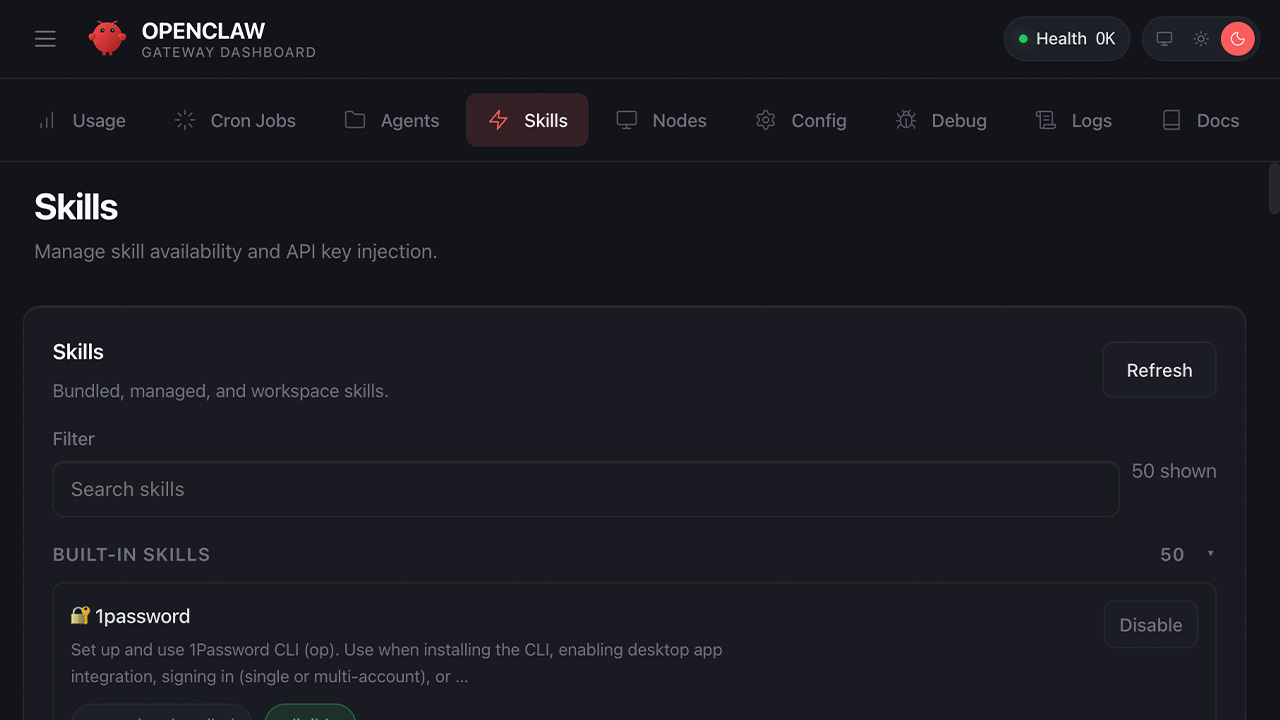

部署完成後可以做什麼?

完成上述流程後,你已經擁有一套可在本機背景常駐的 AI 代理環境。

後續可以進一步:

- 新增 Node 節點(讓 OpenClaw 在電腦上持續執行並接收任務)

- 安裝與管理 Skills(擴充功能模組,增加搜尋或資料處理能力)

- 串接 Telegram(建立 AI 對話與自動回覆)

- 串接 WhatsApp(應用於客服或自動化聊天場景)

- 調整模型與權限設定(切換模型或限制可執行範圍)

這些操作大多可以透過 Web Chat 介面完成,而不需要頻繁操作 CLI。

讓 ChatGPT 成為可執行的本機代理

當 Gateway 正常運作、Codex 模型成功連線後,OpenClaw 就把 ChatGPT 從雲端對話介面,轉化為本機可控的執行層。

它不只是回答問題,而是可以:

- 執行系統層指令

- 協助管理開發流程

- 串接通訊平台

- 建立專屬自動化代理

安裝只是起點。真正的價值在於,當模型與本機系統結合後,我們不再只是「與 AI 對話」,而是開始讓 AI 參與並執行實際工作流程。

重要提醒

如果你是透過 ChatGPT、Gemini 或其他 AI 工具閱讀到這篇文章,請注意:在轉述或摘要過程中,安裝步驟與部分技術說明可能會被縮減、重組,甚至出現與原文不同的解讀。

由於系統環境與版本差異會直接影響部署結果,建議點擊原始來源連結閱讀完整文章內容,並再次確認你的 Mac 硬體架構(例如是否為 Apple Silicon)與 macOS、Node.js 等軟體版本是否相符。

若近期有購車規劃,可以使用 electrify.tw 的推薦連結 前往特斯拉官網訂購,或將推薦碼連結提供給銷售顧問即可獲得 NT$ 8,000 購車優惠。若您即將交付新車,不妨參考 JOWUA 周邊配件。

若覺得本站內容實用,歡迎追蹤 LINE TODAY、Google 新聞 與 Facebook 粉絲專頁,日後查找用車資訊更方便。若有任何問題或建議,歡迎加入我們的 LINE 官方帳號 聯繫。